1.

Introducción

En economía, se define al

“ciclo largo” como el tiempo que transcurre desde que una empresa adquiere un

recurso dinerario (recurso que se puede convertir en dinero), hasta el momento

en que es sustituido por otro, ya sea por la evolución o por la obsolescencia.

En su artículo

Harrison (2014) narra que a finales del siglo XX la economía hizo un estudio

acerca de la evolución de las tecnologías que surgieron en el mundo, y se

estudiaron las principales desde la revolución industrial. Ellos vieron que

finalmente dichas tecnologías se comportaban como una curva “S”, donde al

principio estaba al alcance de muy pocos, evolucionaba rápidamente hasta

saturar el mercado y finalmente, caía ese crecimiento hasta mantenerse en el

tiempo. Vieron que la tecnología de información y la computación se comportaban

del mismo modo, y auguraron que la computación ya estaba llegando a su techo. A

esto le llamaron el “ciclo largo de la computación”. Pero al igual que llega un

momento que se satura, por el mismo fenómeno de supervivencia tecnológica y de

innovación, surgen otras tecnologías que reemplazan las anteriores.

2.

Materiales

y métodos

Esta investigación se

realizó a través de un diseño interpretativo, de tipo documental, el mismo que

determinó el procedimiento de selección, acceso y registro de la muestra

documental.

Se empleó la

metodología del estado del arte, el cual es un estudio analítico de toda la

investigación documental, basándose en publicaciones de revistas científicas (Molina

Montoya, 2005). La metodología tiene como objetivo el hacer un inventario de

todo lo referente a la evolución de la computación desde la computación

tradicional, pasando por los sistemas en las nubes y terminando en la

computación cuántica, la cual está haciéndose muy fuerte en el mundo.

Según Vargas

Guillen (1987), la metodología lleva tres pasos fundamentales y son en los que

este artículo se ha basado:

Contextualización. En esta primera etapa, se

planteó la investigación en estudio, se pusieron los límites, se buscó y

finalmente se obtuvo el inventario documental de todo el tema que se quería

investigar para obtener el artículo

Clasificación. En esta segunda etapa, se

determinaron los parámetros a tener en cuenta para el análisis de la

información, el tipo de documentos que se estudiarían, los aspectos de

cronología, el objetivo del estudio, las diferentes disciplinas informáticas

que enmarcarían el artículo y el nivel de conclusión que se tendría

Categorización

interna.

Finalmente, se sistematizó la investigación, lo cual permitió hacer las

consideraciones necesarias sobre las tendencias y vacíos encontrados durante el

análisis. Esto nos permitió determinar e identificar el tipo de contribución sociocultural

que nos está ofreciendo la computación en la nube y la computación cuántica.

De esta forma,

en este artículo estamos usando la metodología del estado del arte como

herramienta para compilar, sistematizar, reconocer e interpretar la realidad.

3.

Resultados

3.1.

Computación Tradicional y el nacimiento de la

Era de la nube

Se habló mucho de computación

en la nube, pero no se habló de sus orígenes. En este capítulo vamos a hacer

una reseña sobre cuáles fueron las ideas primarias de tener una computación en

la nube y su evolución en el mundo de la informática.

Haciendo un

resumen rápido de la historia de la computación, Villalobos Salazar (2015) nos

dice en su tesis “Del Mainframe al PC”, que las computadoras Eniac y el Mark II

hacen su aparición en el año 1946. Su construcción fue algo revolucionario en

su época porque estaban compuestas de tubos de vacío, el cual permitía

amplificar señales. Fueron construidas con una arquitectura centralista en

donde todo la potencia y facilidades de las entradas de información y su

proceso, estaban concentrados en un mismo lugar, por lo cual fue considerado

como un “Mainframe” o estructura principal de cómputo.

Revisando la

historia de la computación con Garrido López (2008) nos dice que las

computadoras de primera generación utilizaron bulbos de vacío para procesar

información.

En el año 1950

la UNIVAC, Universal Computer por sus siglas en inglés, fue la primera

computadora comercial y usaba 1,000 palabras en su memoria central, y podía

leer cintas magnéticas. Con esta computadora se hizo el censo de 1950 en los

Estados Unidos y se empleaba tarjetas perforadas.

En la década

de 1950, la International Business Machines (IBM) tenía el monopolio de los

equipos de procesamiento de datos a base de tarjetas perforadas, y comenzó a

construir computadores electrónicos siendo su primer producto el IBM 701 en

1953. Pero no fue sino hasta el modelo IBM 650 en 1954 que logró posesionarse

con 1,000 computadores en todo los Estados Unidos entre instituciones privadas

y estatales. El éxito de esta computadora fue su esquema de memoria secundaria

que estaba basado en un tambor magnético que devino con el tiempo en el disco

duro actual.

En 1961,

durante un discurso para celebrar los 100 años del Massachusetts Institute

Technology (MIT), John McCarthy (figura 1) introdujo el concepto de computación

a tiempo compartido, en donde él, preveía que la capacidad y el tiempo de los

servicios de los computadores se vendería como un servicio, tal cual se hacía

con el agua o con el gas. Cabaca (2018) nos cuenta en su artículo que por esa

época existieron algunas empresas como Tymshare National CSS o Dial Data que

proporcionaban servicios de computación basados en tiempo compartido. Esto pegó

mucho en los científicos y de alguna forma se trató de avanzar al respecto, sin

embargo, las limitaciones tecnológicas que se tenía en esa época lo hacían

inviable.

Figura 1. John

McCarthy Figura 2. John

McCarthy

Figura 1. John

McCarthy Figura 2. John

McCarthy

Lo que John

McCarthy manifestó, solamente fue una idea o la percepción que él tenía sobre

la computación, sin embargo, en 1962 Joseph Carlo Robnett Licklider fue el

primero que esbozó una arquitectura y manifestó en qué forma podría darse este

tipo de servicio. Robnett dijo que se podía interconectar miles de computadoras

para acceder a los recursos a datos, desde cualquier parte del mundo: «Consideren

un caso en el que diferentes centros de datos están conectados, con su propio

lenguaje y su forma de hacer las cosas. ¿No sería deseable, incluso necesario

que todos se pongan de acuerdo para usar el mismo lenguaje o, al menos, tener

una convención para preguntar en el lenguaje que habla el otro?». Es así como,

con esta idea, en abril de 1963, en plena Guerra Fría, esbozó un plan de red de

computadoras y lo presentó ante el consejo de ARPA (Agencia de Investigación de

Proyectos Avanzados), donde convenció a los presentes de tener una red que sea

invulnerable a un ataque soviético, ya que se podían conectar los computadores

entre ellas y tener la información compartida. Fue en esos momentos donde nació

ARPAnet, el cual fue el precursor de Internet.

Las

arquitecturas de las computadoras tradicionales fueron evolucionando del

Mainframe, el cual era un computador centralizado, hasta la del

cliente-servidor según nos cuenta Oluwatosin (2014). Esta arquitectura es una

de las más importantes donde una aplicación se modela como un conjunto de

servicios proporcionados por los servidores en línea, y un conjunto de clientes

que usan los servicios de dichos servidores. En este tipo de sistema los

clientes necesitan conocer qué servidores están disponibles y los servicios que

éstos proporcionan, pero normalmente no conocen la existencia de otros

clientes. En este modelo arquitectónico clientes y servidores son procesos

diferentes.

Según el mismo

Cabaca (2018), no fue sino hasta el año de 1996 cuando la empresa COMPAQ

presentó un plan de negocio llamado “Cloud Computing”, liderado por George

Favaloro y un técnico llamado Sean O’Sullivan. Era la primera vez que se

utilizó el término de computación en la nube (Figura 2).

Simultáneamente, y bajo el concepto del “ciclo largo” de la

computación clásica, Harrison (2014) nos dice que singularmente se vieron

cambios drásticos en muchas empresas tecnológicas e innovadoras del mundo.

Pocos notaron cómo empresas como IBM iban vendiendo sus activos. Dichas

empresas visionaron que en el futuro las tecnologías que tenían en el momento,

no les iba a dar los réditos a los cuales estaban acostumbrados, como por

ejemplo el área de impresoras y el de laptops. Visualizaron que la arquitectura

cliente/servidor se pondría obsoleta, tercerizaron el soporte y mantenimiento,

y de esta forma se dedicaron a la investigación para el futuro y al de

encontrar una nueva arquitectura informática. En base a estas innovaciones,

surgió la arquitectura en la nube, basada en una serie de suministros globales

habilitadas por internet, el cual conllevó a un cambio filosófico en el

pensamiento del cliente y del pensamiento ortodoxo computacional, ya que hacía

que el cliente no piense más en abastecerse de tecnología informática, sino más

bien de tener un centro de computación en algún lugar que le dieran las mismas

facilidades que su centro informático, y en el cual no tuviese costos de

mantenimiento, costos de personal técnico y costos de renovación tecnológica. A

su vez, esto hizo que los mismos proveedores de la nube puedan proveer módulos

pre programados para que el cliente, como si fuera un juego de mecano, pueda ir

armando el sistema que necesitase para su empresa. Este empuje de innovación,

más la creciente solicitud de los clientes, hizo que en forma colateral surjan

empresas que hiciesen desarrollos generales para dichas nubes, lo cual facilitó

aún más el ingreso de más clientes.

Sin embargo,

hay que decir que la evolución de la computación clásica hacia la nube no

hubiese tenido mucho avance si no hubiera ido de la mano con la evolución de

las tecnologías de las redes móviles como la 2G, 3G, 4G y 5G, las cuales

generaron que el internet y la conexión a la nube fuese mucho mejor. Esta

evolución, la podemos ver en el cuadro de la tabla 1.

Tabla 1. Evolución de las redes de

Comunicaciones

|

Technology

Features

|

1G

|

2G

|

3G

|

4G

|

5G

|

|

Features

|

|

Start/Deployment

|

1970-1980

|

1990-2004

|

2004-2010

|

Now

|

Now

|

|

Data Bandwitch

|

2kbps

|

64kbps

|

2Mbps

|

1Gbps

|

Higher than 1Gbps

|

|

Technology

|

Analog Celular Technology

|

Digital Celular Technology

|

CDMA 2000 (1xRTT, EVDO, UMTS, EDGE)

|

Wi-Max LTE

Wi-Fi

|

WWWW

|

|

Service

|

Mobile Telephony (voice)

|

Digital Voice, SMS, Higher capacity packetized data

|

Integrated high-quality audio, video and data

|

Dynamic information access, Wearable devices

|

Dynamic information access, Wearable devices with AI capabilities

|

|

Multiplexing

|

FDMA

|

TDMA. CDMA

|

CDMA

|

CDMA

|

CDMA

|

|

Swtiching

|

Circuit

|

Circuit, Packet

|

Packet

|

All Packet

|

All Packet

|

|

Core Network

|

PSTN

|

PSTN

|

Packet N/W

|

Internet

|

Internet

|

Fuente: “Of Next Generation Communication

Network.” - Evolution of Mobile Wireless Communication Networks-1G to 5G (Sharma,

2013).

González et

al. (2020) afirma

en su tesis que hay una barrera muy grande para que todos los seres humanos

tengan internet y son los costos, ya sea por las redes cableadas, las redes

móviles o los satélites. El núcleo del internet es la fibra óptica y atraviesan

mar y tierra. Las conexiones móviles dependen de las torres de telefonía

celular y finalmente el internet satelital, que viene a ser el medio más lento

para conectarse en línea, pero que viene a ser la única opción para poblados

alejados de la civilización o para embarcaciones en alta mar. La lentitud de la

transmisión satelital se explica por la distancia que tienen que recorrer las

señales entre los satélites y el usuario.

Desde el 2020

ya se tiene implementada la tecnología 5G y en donde no sólo se ofrece mayor

ancho de banda, sino que permitirá el desarrollo de servicios en millones de

dispositivos que comparten información. Todos gozarán de una comunicación con

conexión plena. Ya no se tendrá el problema de la baja velocidad a medida que

aumentaba el número de dispositivos conectados.

Gracias a esta

evolución de las redes fue que el concepto de trabajar con un data center remoto

se torna muy familiar. Hoy en día es común escuchar hablar de la computación en

la nube, y también, el saber que personas privadas y empresas de toda índole,

tienen algún tipo de procesamiento basado en la nube y que necesariamente

tienen que interactuar con esos proveedores para poder conseguir las

facilidades necesarias para lo que quieren emprender.

En su artículo

Miner (2020) nos dice, sin embargo, y a pesar de que la nube todavía no llega a

ser de uso mayoritario, ya se puede hacer una evaluación de lo que involucra

usar los servicios de proveedores de nubes, y podemos decir que las

ventajas/desventajas que ofrecen son las siguientes:

Tabla 2. Ventajas y desventajas de la

computación en la nube

|

Ventajas

|

Desventajas

|

|

Pago por uso

|

El tener que conectarse a Internet

|

|

Los recursos pueden ser escalados de acuerdo con demanda

|

Las pruebas y las transferencias de datos

|

|

Están disponibles modelos previamente probados

|

Costos potencialmente más altos en comparación con el

hardware interno

|

|

Algunos proveedores de nube proporcionan interfaces de

usuario de alto nivel que no requieren un conocimiento profundo

|

Pueden tener soporte limitado para diferentes lenguajes y

marcos, por ejemplo: Amazon es compatible con TensorFlow y otros marcos de

ML; Google Cloud ML es compatible con TensorFlow y scikit-learn; Azure

Machine Learning admite marcos de aprendizaje automático basados en Python, como

TensorFlow y PyTorch.

|

|

Algunos proveedores también ofrecen formación gratuita

basada en la red

|

Varona (2020) explica en su publicación, que la

computación clásica y su computación en la nube, llegaron a su cima y

cumplieron su “ciclo largo” cuando el mundo informático se dio cuenta que

muchos procesos de investigación y simulaciones informáticas no podían hacerse

con la tecnología que se estaba empleando. Por más que los microchips redujeron

la velocidad de procesamiento haciéndose más pequeños, tanto que llegaron al

tamaño de nanómetros, se estaba llegando a un punto donde no se podía reducir

más; porque comenzaba a producirse lo que se llamó el “efecto túnel”, donde los

electrones se salen de los canales del circuito por donde deben circular.

3.2.

¿Cómo acceder y

trabajar en la nube?

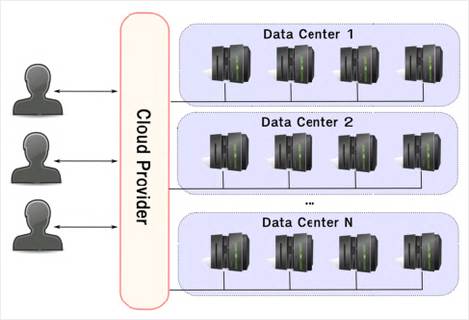

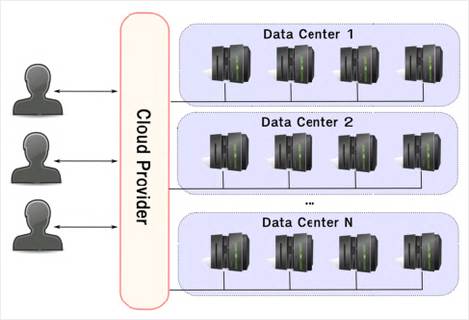

Ante todo, hay que

considerar que un sistema en la nube consta de un proveedor de la nube, uno o

varios centros de datos y clientes (también llamados usuarios de la nube) que

solicitan recursos de la nube (Figura 3).

Figura 3. Vista global de interacción del sistema en la nube

Si uno quiere

trabajar con un proveedor de servicio en la nube, accede y crea su usuario. Por

lo normal, el proveedor le va a solicitar inscribirse y también registrar una

tarjeta de crédito para cualquier requerimiento que haga el usuario.

Dentro de las

facilidades que proveen en la nube, nos brindan un catálogo con todo lo

necesario que el usuario puede necesitar para el uso del servicio de nube.

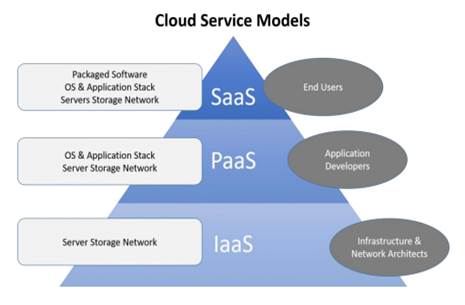

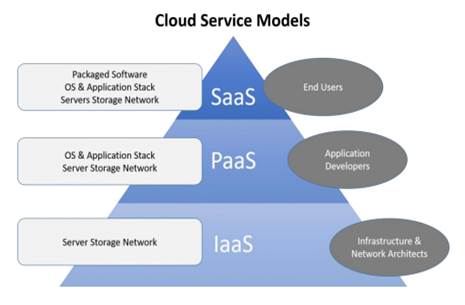

Hay tres tipos

básicos de modelos de servicios de computación en la nube: Infraestructura como

servicio (IaaS), Plataforma como servicio (PaaS) y Software como servicio (SaaS)

en la Figura 4 se muestran todos los modelos de servicio (Noor et al., 2018).

Figura 4. Modelos de servicios en la nube (IaaS, PaaS y SaaS)

Fuente: (Noor et al., 2018).

Infraestructura como servicio (IaaS)

La infraestructura como

servicio es el modelo que forma la base para el despliegue de la tecnología que

se busca en la nube. A través de un proveedor seleccionado, se obtiene acceso

bajo demanda a través de la Internet, y la mayoría de servicios primarios de

TI, tales como computación, almacenamiento, redes y a través de los cuales un

cliente puede instalar y administrar máquinas virtuales, incluidos sistemas

operativos y aplicaciones (Rashid, Hussein, et al., 2018)(Rashid, Zebari, et

al., 2018)(Subhi et al., 2019). El cliente no maneja la infraestructura de la nube,

pero puede tener control sobre los sistemas operativos, el almacenamiento y las

aplicaciones, y puede tener poco control sobre los componentes de red

seleccionados (por ejemplo, firewalls) (Miyachi, 2018). Ejemplo: Amazon (EC2)

ofrece servicios físicos y virtuales a los clientes, incluidas las

especificaciones del consumidor, la memoria, el sistema operativo y el

almacenamiento (Almubaddel & Elmogy, 2016)(Obaid et al., 2020). Como

proveedor de servicios, IaaS proporciona acceso a un flexible recurso de

hardware de última generación que puede ser escalado para satisfacer las

necesidades de procesamiento y almacenamiento del negocio. Además, provee un

paquete centralizado y completamente automatizado, que posee y aloja un

proveedor de servicios y brinda a los clientes servicios informáticos

acompañados de instalaciones de almacenamiento y redes, previa solicitud (Mohan

et al., 2017). Definitivamente, libera a la organización del cliente de toda

responsabilidad de administración y mantención.

Las

características de la IaaS según Almubaddel & Elmogy (2016) son:

· Los servicios de

infraestructura están distribuidos

· La dinámica está permitida

· Tiene un costo variable

· El modelo de precio de la

utilidad

· Requiere múltiples usuarios

en una herramienta de recursos

· Autoservicio y

autoabastecimiento

Plataforma como servicio (PaaS)

La Plataforma como

servicio es el modelo de servicio en la nube en el que se accede a múltiples

herramientas combinadas de hardware y software a través de proveedores de

servicios. Proporciona un marco o medio aceptable para que el desarrollador

cree aplicaciones y programas y los distribuya en la red sin tener que instalar

o administrar el entorno de producción. Para ejecutar el software disponible o

crear y probar el último, PaaS permite a los clientes alquilar servidores

definidos por software y recursos adjuntos (Haji et al., 2018)(Osanaiye et al.,

2019). El cliente no está a cargo del hardware de la nube, como servidores, bases

de datos, middleware, redes, almacenamiento y sistema operativo. Sin embargo,

el cliente controla las aplicaciones y su configuración (Bokhari et al., 2016).

El motor de aplicaciones de Google y Microsoft Azure son los ejemplos más

recientes de PaaS. Se centra en la creación y el uso de software en la nube por

parte de implementadores y desarrolladores. La arquitectura multicapa es

altamente escalable, p. Ej. Salesforces.com y Azure. Este modelo utiliza

herramientas y / o bibliotecas que actúan como marco (Hussein & Khalid,

2016). Este servicio hace ahorrar dinero y tiempo al cliente, ya que no le

dedica tiempo a la instalación y configuración de la arquitectura, centrándose

únicamente en el desarrollo, ejecución y gestión de las aplicaciones.

Las

características de PaaS para Almubaddel & Elmogy (2016) son:

· Arquitectura para

multi-tenants

· Acceso granular de

seguridad / uso compartido (modelo de permisos)

· Flujo de trabajo robusto

de motor / capacidad

· Dispositivo integrado

escalabilidad

· Incluido equilibrio de

carga y conmutación por error

· Interfaz de usuario

personalizable / programable, (vii) personalización de base de datos ilimitada

· Plataforma de integración

escalable "habilitada para servicios"

· Autoservicio y suministro

· Pila de middleware

preconstruida.

Software como servicio (SaaS)

Software como un servicio,

es el modelo de servicio en la nube que da la oportunidad de utilizar

aplicaciones en forma completa, ejecutarlas y gestionarlas por medio del

proveedor de servicios. Se puede acceder a las aplicaciones a través de una

interfaz de aplicación web, como un navegador (por ejemplo, un correo

electrónico basado en la web) o la interfaz de la aplicación y desde

dispositivos de cliente separados (Al-zebari et al., 2019; Jacksi &

Zeebaree, 2015; Subhi et al., 2019). Con la posible excepción de una pequeña

gama de configuraciones de dispositivos para los consumidores, el cliente no

maneja ni monitorea la infraestructura de la nube, incluida la red, los

servidores, los sistemas operativos, el almacenamiento o incluso las

aplicaciones específicas. SaaS se centra en la interfaz del usuario final, ya

que los usuarios finales pueden usar y administrar este software creado en la nube.

Ejemplos de SaaS son CRM, aplicaciones de Google, Deskaway y Wipro w-SaaS (Miyachi,

2018). El SaaS hace que el cliente se libere para centrarse únicamente en cómo

utilizar mejor ese software.

Un ejemplo

común de SaaS es una solución de gestión de las relaciones con los clientes

(CRM) basada en la web. Se almacenan y gestionan todos los contactos a través de CRM sin necesidad de

actualizar el software a la última versión o de mantener el servidor y el

sistema operativo en el que se ejecuta el software.

Las

características de SaaS son (Almubaddel & Elmogy, 2016):

· Aplicaciones que están

abiertas a los consumidores en cualquier momento

· Los proveedores de SaaS no

tienen sus aplicaciones alojadas en las instalaciones del cliente, sino que

alojan el software ellos mismos a terceros

· Se puede acceder a los

programas mediante una interfaz web, que ofrece la funcionalidad y los datos

relacionados desde prácticamente cualquier punto en el que se pueda acceder a

una conexión a Internet. Esta disposición también permite que varios usuarios

sean flexibles. Todavía deja cierta discreción del cliente en manos del

cliente, por ejemplo, puede dividir la aplicación con sus clientes y gastar

mucho mejor en ellos, y el modelo SaaS también ayuda a los usuarios a aceptar

las actualizaciones y reparaciones de la aplicación de forma simultánea y

fácil.

3.3.

La mecánica

cuántica

La evolución de la tecnología

TI va desde la computación clásica, que se inició con los mainframes, siguiendo

con la tecnología cliente-servidor y concluyendo con el tema tratado en el

párrafo anterior; la computación en la nube. Inclusive, hay tecnologías

colaterales que cumplieron su “ciclo largo” como las picadoras de tarjeta, las

impresoras de punto, los computadores de escritorio, diskettes y solamente por

nombrar algunas de ellas.

Para entender

la computación cuántica, es necesario precisar algunos conceptos básicos y

revisar su historia y evolución hasta ahora. Primero se realizará un retroceso

en el tiempo para ver los orígenes de la ciencia, física o mecánica cuántica.

Cuando se

habla de la mecánica cuántica, inmediatamente llega a nuestra mente lo

aprendido en las clases de física: naturaleza atómica y subatómica, fuerzas

electromagnéticas y hasta incluso, la galaxia atómica. Y efectivamente, aquí es

donde se explica el comportamiento de la materia y la energía.

El estudio de

la mecánica cuántica se remonta a inicios del siglo XX cuando en la física

clásica se estudiaba temas de Gravitación Universal y de Teoría

electromagnética; con estos temas se comprende lo complejo del tema y se busca

una explicación al respecto. La mecánica cuántica confirma que toda materia

atómica que está en equilibrio absorbe y emite energía. Posteriormente, Max

Planck agregó a esto, que además de que la materia absorbe y emite Energía, lo

hace en forma de cuantos de luz o fotones de energía (Figura 5).

Figura 5. Átomo emitiendo y absorbiendo

cuantos de luz o fotones de

energía Figura 6. Esfera de Bloch

cuantos de luz o fotones de

energía Figura 6. Esfera de Bloch

El describir

el resto de las teorías cuánticas, sería más complejo, y en presente trabajo se

detallarán únicamente los temas necesarios para una mejor comprensión y

entendimiento del funcionamiento de la computación cuántica.

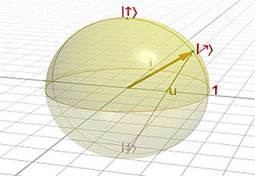

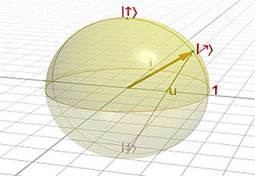

Ahora, para

entender del tema es necesario imaginar la forma de poder saber la ubicación

exacta de un cuanto de luz (quantum o fotón) en determinado momento del tiempo.

Su movimiento es tan rápido que ni con la imaginación alcanza para determinarla

o imaginarla. No se puede predecir o confirmar su posición de ninguna manera.

Sin embargo; si se puede imaginar la ubicación en donde podría estar y se puede

representar vectorialmente dentro de la Esfera de Bloch (Figura 6), esfera

figurativa que se hace uso para su entendimiento. En la figura se visualiza que

el vector que une el quantum con un punto de la esfera podría tener posiciones

infinitas, dependiendo de donde se encuentre el quantum en ese momento.

Inclusive, podría tener posiciones negativas para poder ubicarlo. Y si se

utiliza la imaginación se puede profundizar un poco más, incluso se podría

confirmar que puede estar en todos los estados al mismo tiempo. En el mundo

cuántico una partícula puede poseer dos o más valores de una cantidad

observable.

Varona (2020) dice en su trabajo que la

primera persona en aplicar principios de la mecánica cuántica a la computación

fue Paul Benioff en 1981. Posteriormente, Richard Feynman planteó que las

computadoras cuánticas se basasen en las leyes de la mecánica cuántica, con lo

cual podría hacerse cálculos muy complejos de forma muy rápida. Es él, quien

acuñó el término “computador cuántico”. Para la época, estas ideas fueron muy

revolucionarias y tuvieron mucho asidero en la mente, ya que todo era teoría.

Con esto se visualizó y confirmó que el comportamiento en los ambientes

macroscópicos es muy diferente a los comportamientos en los ambientes

cuánticos, es la diferencia entre la física newtoniana y la física cuántica, y

es la diferencia entre la computación clásica y la computación cuántica. Mundos

diferentes, lógica diferente.

3.4.

La computación

cuántica

La lógica de la

computación cuántica es completamente diferente a la de la computación clásica.

En la computación cuántica se introducen las leyes de la mecánica cuántica,

mientras que, en la clásica, los bits pueden tomar valores de 0 ó 1; a

diferencia de la computación cuántica, los bits cuánticos o qubits pueden tomar

ambos valores a la vez, o incluso valores intermedios, tal como lo demuestra la

Esfera de Bloch. Los qubits pueden estar en superposiciones cuánticas de 0 y 1,

lo mismo que un fotón puede estar en superposiciones de la polarización

horizontal y la vertical. Dos bits pueden representar los cuatro estados: 00,

01, 10 y 11, pero solamente pueden tomar uno de los cuatro estados. Un sistema

de dos qubits también puede representar los cuatro estados 00, 01, 10 ó 11,

pero podría tomar los cuatro estados a la vez. Y como se explicó en el capítulo

anterior, esto permite que se puedan realizar varias operaciones a la vez,

gracias al comportamiento del mundo cuántico. Si con dos qubits puede

presentarse cuatro estados al mismo tiempo, con tres qubits serán 8

posibilidades en forma simultánea, entonces con 1000 qubits las posibilidades

exponenciales serían mucho más grandes que las computadoras clásicas (Nuribal,

2020).

Siguiendo con Varona

(2020), nos dice que durante los años 90 aparecieron los primeros algoritmos

cuánticos y con ellos las primeras aplicaciones y máquinas capaces de realizar

cálculos cuánticos. Y es en el año de 1998, que la Universidad de Oxford

anunció que procesó información utilizando dos qubits.

Cuando miramos

retrospectivamente, se puede asimilar los conocimientos y pensar en un mundo de

ciencia ficción, donde las computadoras ya están al alcance de las personas y

lo mejor de todo, uno ya puede experimentar con computadoras cuánticas en los cloud

cuánticos que están al servicio de todo el mundo, desde empresas que ya tienen

su espacio en dichos computadores, como en personas comunes que pueden

conectarse para experimentar o aprender.

En estos

momentos no se puede comparar la computación clásica con la cuántica. No se

puede confirmar si una es mejor que la otra; sin embargo, se puede concluir que

la clásica ya está en plena vigencia y con su crecimiento ínfimo, mientras que

la computación cuántica está en pleno crecimiento y nos ofrece un futuro que en

muchos casos es inimaginable.

Sin embargo,

ya se avizora que las computadoras cuánticas superarán a las computadoras

clásicas en muchas aplicaciones que las clásicas no las pueden manejar bien.

Esto puede traer recuerdos a cuando teníamos una calculadora científica y las

computadoras clásicas. Eran dos objetos muy diferentes, y aun así, los expertos

confirmaban que las computadoras clásicas podían resolver problemas

inimaginables. Ahora, se confirma que, en una analogía, que sucederá lo mismo.

Mientras que la computación clásica ya tiene su sitial en los negocios, en la

contabilidad, en la educación y en un sinfín de servicios, la computación

cuántica se abrirá paso aumentando la velocidad en los procesamientos de datos

científicos complejos, lo que traerá consigo grandes éxitos que seguirán

potenciando la investigación y el desarrollo.

Zeilinger (2000) nos dice que un

computador cuántico puede funcionar como una superposición de muchos datos de

entrada a la vez. Puede, por ejemplo, ejecutar un algoritmo simultáneamente

sobre un millón de datos de entrada utilizando sólo tantos qubits como bits

necesitaría un computador ordinario para ejecutar el algoritmo una sola vez

sobre un solo dato de entrada. Los algoritmos que se ejecutan con computadores

cuánticos pueden resolver ciertos problemas más deprisa (con menos pasos de

computación) que cualquier algoritmo conocido ejecutado en un ordenador

clásico.

Además, Zeilinger

(2000) nos explica en su artículo que la teletransportación ya es un hecho,

pero no en los términos de transportar humanos, sino en el de transferir qubits

de un lado a otro. Al hacer esta transferencia, solamente se está transmitiendo

información, y la velocidad de esta solamente tiene el límite de la velocidad

de la luz. Por ahora, la teletransportación humana todavía quedará en la

ciencia ficción.

La

teletransportación consiste en que se pueda transferir información de A a B,

sin que esa información siga un rastro. Lo normal cuando enviamos información

de A a B es que haya entre ellas una línea telefónica u ondas de radio y

cualquier otro medio de transporte. En la teletransportación cuántica ya no

habrá nada de eso (Vodafone, 2016).

Si seguimos

pensando en comunicaciones, veremos que el construir satélites cuánticos para

transferencia de información y con la teletransportación, los datos se

transmitirían a la tierra a la velocidad límite con la que viajan los fotones,

el de la luz.

Díaz Domínguez

(2010) nos

habla en su artículo que los métodos de criptología actual basan su seguridad

en la enorme cantidad de cálculos que tendría que realizar una computadora

moderna para descifrar claves de seguridad que en promedio tomaría años en

lograrlo. Sin embardo, nos dice que, con la computadora cuántica, esos mismos

cálculos se realizarían en cuestión de minutos, haciendo vulnerable todos los

métodos criptográficos actuales. Esto conlleva que, en la actualidad, se vienen

desarrollando nuevos métodos de criptografía que sean intrínsecamente

invulnerables aún frente a la computadora cuántica.

Con la

computación cuántica todavía se está experimentando, pero se prevé aplicaciones

muy revolucionarias como, por ejemplo:

Finanzas: Mejoras en los sistemas

de detección de fraude y de simulación. Mayor optimización de las carteras de

inversiones

Biomedicina:

Nuevas

investigaciones del ADN humano, demasiado complejo para los ordenadores

convencionales. Personalización genética de tratamientos médicos

Ciberseguridad: La computación cuántica

amenaza los sistemas actuales de encriptación, pero también ofrece una nueva

técnica para asegurar el envío de comunicaciones sensibles. Con esta técnica,

basada en el envío de señales lumínicas, cualquier intromisión del sistema es

automáticamente detectada

Movilidad y

transporte: Los ordenadores cuánticos son muy útiles para un diseño más eficiente:

Airbus cuenta con un ordenador cuántico para optimizar cada centímetro de sus

naves analizando todas las variables físicas de la navegación. Además, los

qubits darán un enorme salto cualitativo a los sistemas de planificación del

tráfico y optimización de rutas

La computación

cuántica todavía está en sus inicios; por ello, el construir las computadoras

requiere un desafío muy grande en cuanto a tecnología e inversión. Todavía se

mantiene en secreto el modo de construirlos y el modo en que se manejan; y para

poder crear sus algoritmos requiere pensar de una forma diferente, requiere que

el desarrollador pueda cambiar su chip.

La computación

cuántica ya está sobre la mesa. Ahora toca ver la infinidad de aplicaciones que

se pueden obtener de ella.

3.5.

Principales

proveedores de computación cuántica en la nube

La computación en la nube

se viene expandiendo desde hace muchos años, y por ende los proveedores se van

proliferando. Los servicios que se ofrecen en forma comercial computación en la

nube están creciendo cada día más, y lo que se ha visto en los últimos 2 años,

es una carrera acelerada para ofertar servicios. En este capítulo se hará una

breve reseña de los principales proveedores de computación cuántica en la nube

que se tiene en el mundo.

Tabla 3. Principales servicios de 4

proveedores de servicios en nube

|

IBM

|

Google

|

AWS

|

Azure

|

|

Servicios de Computación en nube

|

Cloud

Foundry

|

Compute

Engine

|

Amazon

EC2

|

Virtual

Machines

|

|

IBM

Cloud Code Engine

|

Migrate

for Compute Engine

|

Amazon

Elastic Container Service

|

Container

Instances

|

|

IBM

Cloud Bare Metal Servers

|

App

Engine

|

Amazon

Lightsail

|

App

Service

|

|

Servicios de Redes de nubes

|

Domain

Name Services

|

Virtual

Private Cloud (VPC)

|

Amazon

VPC

|

Azure

Virtual Network

|

|

IBM

Cloud Content Delivery Network

|

Cloud

DNS

|

Amazon

Route 53

|

Azure

DNS

|

|

IBM

Cloud Direct Link

|

Cloud

CDN

|

AWS

Direct Connect

|

Azure

Content Delivery Network

|

|

IBM

Cloud Interned Services

|

Cloud

Load Balancing

|

Elastic

Load Balancing

|

Azure

Load Balancer

|

|

Servicios de Transferencia de Datos

|

IBM

Cloud Backup

|

Cloud

Storage

|

Amazon

EBS

|

Disk

Storage

|

|

IBM

Cloud Block Storage

|

Persistent

Disk

|

Amazon

EFS

|

File

Storage

|

|

IBM

Cloud File Storage

|

Cloud

Filestore

|

Amazon

S3

|

Blob

Storage

|

|

IBM

Cloud Mass Data Migration

|

Data

Transfer Services

|

Data

Transfer Services

|

|

|

Servicios de Seguridad en la nube

|

IBM

Cloud App ID

|

Cloud

IAM

|

Amazon

Cognito

|

Azure

Active Directory

|

|

IBM

Cloud Certificate Manager

|

Cloud

Audit Logs

|

AWS

Shield

|

Key

Vault

|

|

IBM

Cloud Data Shield

|

Cloud

Security Commander Center

|

AWS

Security Hub

|

Azure

Security Center

|

|

IBM

Cloud Hardware Security Module

|

|

AWS

Firewall Manager

|

|

|

Servicios de Análisis de la nube

|

IBM

Analytics Engine

|

BigQuery

|

Amazon

Athena

|

Data

Lakes Analytics

|

|

IBM

Cloud SQL Query

|

Cloud

Dataflow

|

Amazon

EMR

|

HD

Insight

|

|

IBM

DB2 Warehouse on Cloud

|

Google

Data Studio

|

Amazon

Redshift

|

Azure

Synapse Analytics

|

|

Servicios de BD en la nube

|

IBM

Cloud DB for Elasticsearch

|

Cloud

SQL

|

Amazon

RDS

|

Azure

SQL Database

|

|

IBM

Cloud DB for EnterpriseDB

|

Cloud

Bigtable

|

Amazon

DocumentDB

|

Azure

Cosmos DB

|

|

IBM

Cloud DB for etdc

|

Cloud

Spanner

|

Amazon

Managed Apache Cassandra Service

|

Azure

Database for MySQL

|

|

Servicios de Inteligencia Artificial

|

IBM

Watson Assistant

|

AI

Platform

|

Amazon

Comprehend

|

Azure

Bot Service

|

|

IBM

Watson Discovery

|

Vision

AI

|

Amazon

Polly

|

Bing

Custom Search

|

|

IBM

Watson Knowledge Studio

|

Speech-to-Text

|

Amazon

Translate

|

Machine

Learning Studio

|

|

Servicios de cadenas de bloqueos de nubes

|

IBM

Blockchain Platform

|

|

Amazon

Managed BlockChain

|

Azure

Blockchain Service

|

|

|

Amazon

Quantum Ledger Database

|

Azure

Blockchain Workbench

|

|

|

|

Azure Blockchain Tokens

|

|

Principales IO disponibles

|

IBM

Edge Application Manager

|

Cloud

IoT Core

|

AWS

IoT Core

|

Azure

IoT Hub

|

|

IBM

Watson IoT Platform

|

Edge

TPU

|

AWS

IoT Button

|

Azure

IoT Central

|

|

|

AWS

IoT Analytics

|

Azure

IoT Edge

|

IBM

Wooton (2017) indica que IBM fue uno de

los primeros en lanzar el servicio de Quantum, servicio Quantum (QAAS) en mayo

del 2016. En esta primera versión, los usuarios sólo podían usar el GUI y

conectarse al HW. Sin embargo, faltaba la interacción de código, y en marzo del

2017 lanzó Qiskit, para que el usuario pueda experimentar con un procesador

cuántico y el simulador.

La nube de IBM

para la tecnología Quantum incluye, para cualquier usuario común, acceso a

tutoriales para el uso del computador, prototipos y a un libro interactivo. A febrero

del 2021, existían más de 20 dispositivos en el servicio, seis de los cuales estaban

disponibles gratuitamente para el público. Con este servicio gratuito, se podían

ejecutar algoritmos, experimentos y tutoriales sobre todo lo que podía ser

posible con la computación cuántica.

IBM es una de

las empresas tecnológicas que tiene más avanzada su oferta de computación

cuántica mediante el cloud computing, gracias a su servicio en la nube IBM

Quantum Experience. En estos momentos hay muchos investigadores académicos que

han hecho publicaciones de las experiencias que tuvieron con la utilización de

esta nube, así como también los profesores académicos hacen que sus alumnos lo

utilicen con ejemplos e investigaciones.

Amazon Web Service (AWS)

Amazon nos dice que en el

año 2019 se lanzó Amazon Braket. Esta nube permite a sus clientes experimentar

con diferentes tipos de hardware cuántico, cada uno con una implementación

física diferente. Cuando salió para su uso, AWS explicó que, por primera vez,

era posible comparar diferentes tecnologías en paralelo y que se podía trabajar

entre ellas cambiando solo una línea de código. Con esto, se dijo que la

computación cuántica encajaría en una infraestructura de TI basada en la nube,

trabajando junto con otros recursos computacionales, combinando complejos

problemas operativos como la usabilidad, la seguridad y la administración de

recursos. Amazon también lanzó su kit de desarrollo para la nube llamado AWS

CDK (Severini, 2021)(Vass, 2018).

Azure

Lopez Bravo (2021) refiere que Azure Quantum

es un servicio de Microsoft Azure que se puede utilizar para ejecutar programas

de computación cuántica o resolver problemas de optimización en la nube. Con

las herramientas y los SDK de Azure Quantum, se puede crear programas cuánticos

y ejecutarlos en diferentes máquinas y simuladores cuánticos.

El servicio

Azure Quantum ofrece acceso a proveedores de dispositivos de computación

cuántica y le permite ejecutar sus programas cuánticos Q # en hardware real. Q

# es un lenguaje de programación de código abierto de Microsoft para

desarrollar y ejecutar sus algoritmos cuánticos. Azure Quantum también ofrece

la opción de ejecutar algoritmos en computadoras cuánticas simuladas para

probar el código creado por el usuario (Lopez Bravo, 2021a).

Google Cloud Platform (GCP)

En su publicación, Varona

(2020) nos dice que Google salió a la luz con su computadora Sycamore, una

máquina cuántica que en sólo 200 segundos pudo ejecutar una tarea que a la

supercomputadora más rápida del mundo le tomaría 10,000 años. Con esto, Google

alcanzó de forma oficial la “supremacía cuántica”, es decir, que había logrado

construir un dispositivo de computación cuántica que podía dar solución a

problemas que la computación clásica no podía. Juntamente con esto, Google

lanzó su Google Applicaction Engine SDK para el desarrollo de programas

cuánticos.

4.

Conclusiones

La evolución de la computación

tradicional empezó de manera lenta y metódica, para que, con la llegada de las

conexiones de redes, la internet y las velocidades de transmisión y

almacenamiento, terminaran en la Computación en la nube. Esta tecnología le

ofrece a un individuo o empresa una nueva forma de realizar su trabajo en forma

diaria, con lo cual hace que el cliente tenga todo lo necesario sin tener que

gastar en mantenimiento de un Centro de Información. Es así que en la

Computación en la nube podemos encontrar la mayoría de los servicios que nos

ofrece la Informática, como por ejemplo la Infraestructura como Servicio (IaaS

por sus siglas en inglés) que nos ofrece computación, almacenamiento, redes

físicas y virtuales, sistemas operativos y aplicaciones; la Plataforma como

Servicio (PssS por sus siglas en inglés), por medio del cual un cliente puede

acceder a múltiples herramientas de software y hardware para que pueda

controlar todos sus aplicaciones y sus configuraciones en el ambiente creado; y

finalmente tenemos el Software como Servicio (SaaS por sus siglas en inglés) en

el cual una empresa en la nube nos ofrece aplicaciones completas que se

ejecutan y gestionan por medio del proveedor de la nube.

Sin embargo,

también la computación tradicional está llegando al final de su “Ciclo Largo”.

Cada día es más difícil superar la velocidad de transmisión de datos en los

microchips, haciendo que lleguemos a un límite o al final del Ciclo. Es allí

donde grandes empresas de computación iniciaron sus investigaciones de una

nueva tecnología llamada Computación Cuántica, logrando que en este último

quinquenio se lograse tener Clouds Cuánticos en forma comercial.

La tecnología

cuántica todavía se encuentra en sus inicios. Con el correr de los años se irán

descubriendo muchas más cosas en la cual será útil, como también, se irán

inventando más tecnología para su mejor uso. Esto es como estar en los años 50

de la computación clásica. Según Mark Zuckerberg, la computación cuántica

estará madura para el 2030 y nos traerá cosas sorprendentes.

Los físicos

aseguran que la comunicación cuántica revolucionará la informática. Ellos

manifiestan que esta tecnología enviará y recibirá datos sin rastro, sin cables

y sin ondas, y por medio de satélites. Garantizar la seguridad y evitar el

cibercrimen serán sus principales aplicaciones.

Como derivado

de la comunicación cuántica, se prevé llegar a la criptografía cuántica, que

será un método seguro de enviar información de un emisor a un receptor. Los

especialistas dicen que será tan seguro, que será imposible descifrar el

código.

Así mismo, y

derivado también de la comunicación, se tendrá como objetivo utilizar la

teletransportación para conectar los ordenadores cuánticos. Al final, la idea

es tener criptografía cuántica en todo el mundo y teletransportación cuántica

desde el satélite a la tierra, y de la tierra al satélite para conectar entre

ellos varios ordenadores cuánticos en distintas ubicaciones. El futuro deparará

el que se tenga una red de satélites cuánticos, lo que actualmente está muy

inmaduro.

Por último, es

muy importante subrayar que toda tecnología descubierta siempre tuvo una

transición, y que, en muchos casos, no se supo de sus aplicaciones sino mucho

después, cuando se juntaron el tiempo, la tecnología y la oportunidad.

Agradecimiento

Agradecimiento especial a

la Mg. Norma León Lescano, quién con mucha paciencia y esmero nos supo guiar

para terminar este artículo.

Referencias

bibliográficas

Al-zebari, A. A., Jacksi, K.,

Selamat, A., & Zeebaree, R. M. (2019). ELMS–DPU Ontology Visualization with Protégé VOWL and Web

VOWL. Journal of Advanced Research in Dynamical and Control Systems, 11(1),

478–485. https://www.jardcs.org/abstract.php?id=97#

Almubaddel, M., & Elmogy, A. M.

(2016). Cloud Computing Antecedents, Challenges, and Directions. Proceedings

of the International Conference on Internet of Things and Cloud Computing,

1–5. https://doi.org/10.1145/2896387.2896401

Bokhari, M. U., Shallal, Q. M., &

Tamandani, Y. K. (2016). Cloud computing service models: A comparative study. 3rd

International Conference on Computing for Sustainable Global Development

(INDIACom), 890–895. https://ieeexplore.ieee.org/document/7724392

Cabaca, T. (2018). ¿Quién inventó

el Cloud Computing? MCPRO.

https://www.muycomputerpro.com/2018/07/03/historia-cloud-computing

Díaz Domínguez, C. M. (2010). Introducción

a la criptografía cuántica experimental: Distribución de una clave cuántica por

aire libre [Universidad Nacional de Ingeniería].

http://cybertesis.uni.edu.pe/handle/uni/1804

Garrido López, C. A. (2008). Historia

de la computación [Universidad de San Carlos de Guatemala].

http://biblioteca.usac.edu.gt/tesis/07/07_2010.pdf

González, J., Juan, & Núñez, A.

(2020). Internet interestelar [Universidad Internacional de Ciencia y

Tecnología].

http://www.idi-unicyt.org/wp-content/uploads/2020/07/INFORME-Jose-Juan-y-Aaron-verfión-final-16072020-.pdf

Haji, L. M., Zeebaree, S. R. M.,

Jacksi, K., & Zeebaree, D. Q. (2018). A State of Art Survey for OS

Performance Improvement. Science Journal of University of Zakho, 6(3),

118–123. https://doi.org/10.25271/sjuoz.2018.6.3.516

Harrison, C. (2014). Roads to Smarter

Cities. In Concept-Oriented Research and Development in Information

Technology (pp. 55–69). John Wiley & Sons, Inc.

https://doi.org/10.1002/9781118753972.ch4

Hussein, N. H., & Khalid, A.

(2016). A Survey of Cloud Computing Security Challenges and Solutions. International

Journal of Computer Science and Information Security, 14(1), 52–56.

https://e-tarjome.com/storage/btn_uploaded/2019-02-27/1551264298_9355e-tarjome-English.pdf

Jacksi, K., & Zeebaree, R. M.

(2015). Effects of Processes Forcing on CPU and Total Execution-Time Using

Multiprocessor Shared Memory System. International Journal of Computer

Engineering in Research Trends, 2(4), 275–279.

https://www.ijcert.org/issue_des.php?id=312

Lopez Bravo, S. (2021a). Understanding

quantum computing. Microsoft. https://docs.microsoft.com/en-us/azure/quantum/overview-understanding-quantum-computing

Lopez Bravo, S. (2021b). What is

Azure Quantum? Microsoft.

https://docs.microsoft.com/en-us/azure/quantum/overview-azure-quantum

Miner, R. (2020). Developing an AI

project. Journal of Medical Imaging and Radiation Sciences, 51(4),

550–559. https://doi.org/10.1016/j.jmir.2020.06.010

Miyachi, C. (2018). What is “Cloud”?

It is time to update the NIST definition? IEEE Cloud Computing, 5(3),

6–11. https://doi.org/10.1109/MCC.2018.032591611

Mohan, L., Pandey, R., Bisht, S.,

& Pant, J. (2017). A Comparative Study on SaaS, PaaS and IaaS Cloud

Delivery Models in Cloud Computing. International Journal on Emerging

Technologies, 8(1), 158–160.

https://www.researchtrend.net/ijet/pdf/41-S-834.pdf

Molina Montoya, N. P. (2005). ¿Qué es

el estado del arte? Ciencia & Tecnología Para La Salud Visual y Ocular,

5, 73. https://doi.org/10.19052/sv.1666

Noor, T. H., Zeadally, S., Alfazi,

A., & Sheng, Q. Z. (2018). Mobile cloud computing: Challenges and future

research directions. Journal of Network and Computer Applications, 115,

70–85. https://doi.org/10.1016/j.jnca.2018.04.018

Nuribal. (2020). Computación

Clásica vs Computación Cuántica. Nuribal.

https://nubiral.com/computacion-clasica-vs-computacion-cuantica/

Obaid, K. B., Zeebaree, S., &

Ahmed, O. M. (2020). Deep Learning Models Based on Image Classification: A

Review. International Journal of Science and Business, 4(11),

75–81. https://ijsab.com/wp-content/uploads/612.pdf

Oluwatosin, H. S. (2014).

Client-Server Model. IOSR Journal of Computer Engineering, 16(1),

57–71. https://doi.org/10.9790/0661-16195771

Osanaiye, B., Ahmad, A., Mostafa, S.,

Mohammed, M., Mahdin, H., Zeebaree, S., Ibrahim, D., & Obaid, I. (2019).

Network Data Analyser and Support Vector Machine for Network Intrusion

Detection of Attack Type. Revista AUS, 91–104.

Rashid, Z. N., Hussein, S. K., &

Mohammed Zebar Sulaimani, S. R. (2018). Client/Servers Clustering Effects on

CPU Execution-Time, CPU Usage and CPU Idle Depending on Activities of

Parallel-ProcessingTechnique Operations. International Journal of Scientific

& Technology Research, 7(8), 106–111.

Rashid, Z. N., Zebari, S. R. M., Sharif,

K. H., & Jacksi, K. (2018). Distributed Cloud Computing and Distributed

Parallel Computing: A Review. 2018 International Conference on Advanced

Science and Engineering (ICOASE), 167–172.

https://doi.org/10.1109/ICOASE.2018.8548937

Severini, S. (2021). Hello World.

Amazon Web Services.

https://aws.amazon.com/es/blogs/quantum-computing/hello-quantum-world/

Sharma, P. (2013). Evolution of

Mobile Wireless Communication Networks-1G to 5G as well as Future Prospective

of Next Generation Communication Network. International Journal of Computer

Science and Mobile Computing, 2(8), 47–53.

https://www.ijcsmc.com/docs/papers/August2013/V2I8201317.pdf

Subhi, Z., Rizgar, Z., Karwan, J.,

& Dathar, A. (2019). Security Approaches For Integrated Enterprise Systems

Performance: A Review. International Journal of Scientific & Technology

Research, 8(12), 2485–2489.

https://www.ijstr.org/final-print/dec2019/Security-Approaches-For-Integrated-Enterprise-Systems-Performance-A-Review.pdf

Vargas Guillen, G. (1987). Seis

modelos alternativos de investigación documental para el desarrollo de la

práctica universitaria en educación : el caso del Proyecto de

Extensión REDUC. Educación Superior y Desarrollo, 5(3), 7–37. http://catalogo.pedagogica.edu.co/cgi-bin/koha/opac-detail.pl?biblionumber=167739#

Varona, B. (2020). Introducción a

la computación cuántica - Parte I. Techedge.

https://www.techedgegroup.com/es/blog/introduccion-computacion-cuantica-i

Vass, B. (2018). National Quantum

Initiative Act: An Important Step for American Leadership. Amazon Web

Services.

https://aws.amazon.com/es/blogs/publicsector/national-quantum-initiative-act-an-important-step-for-american-leadership/

Villalobos Salazar, H. (2015). Del

Mainframe al PC, una aproximación a la historia de la informática en la

Universidad del Valle (1985-1990) [Universidad del Valle].

http://hdl.handle.net/10893/15323

Vodafone. (2016). El

teletransporte de información, clave para las comunicaciones del futuro. El

Futuro Es Apasionante de Vodafone. https://www.youtube.com/watch?v=D50hOASNX_w

Wooton, J. (2017). Quantum

Battleships: The first multiplayer game for a quantum computer. Medium.

https://decodoku.medium.com/quantum-battleships-the-first-multiplayer-game-for-a-quantum-computer-e4d600ccb3f3

Zeilinger, A. (2000). Teletransporte cuántico. Investigación

y Ciencia, 46–54.

https://www.investigacionyciencia.es/revistas/investigacion-y-ciencia/computacin-y-transporte-cunticos-317/teletransporte-cuntico-3320

Financiamiento

Ninguno.

Conflicto de

intereses

El artículo no presenta

conflicto de intereses.

Contribución de autores

Vargas-Torres-Céliz,

Ezequiel; Mollinedo-Chávez, Leonor; Lara-Baltazar, Grigori y Ricaldi-Arauzo,

Reymer cumplieron el rol de Investigador y redactor del artículo.

![]() 0000-0001-6414-7827]1;

Mollinedo-Chávez, Leonor [

0000-0001-6414-7827]1;

Mollinedo-Chávez, Leonor [![]() 0000-0002-2987-9990]1;

Lara-Baltazar, Grigori [

0000-0002-2987-9990]1;

Lara-Baltazar, Grigori [![]() 0000-0002-5343-9549 ]1; Ricaldi-Arauzo,

Reymer [

0000-0002-5343-9549 ]1; Ricaldi-Arauzo,

Reymer [![]() 0000-0001-6780-5573]1

0000-0001-6780-5573]1